英特尔在加速AI的光学芯片方面取得了进展

光子集成电路或光学芯片比其电子对应物具有许多优势,包括降低功耗和处理速度。这就是为什么一群研究人员认为他们可能会为人工智能工作量量身定制,以及为什么有些人 - 包括麻省理工学院博士。候选人Yichen Shen--已经成立公司将其商业化。Shen的创业公司 - 总部位于波士顿的Lightelligence,迄今为止已筹集了1070万美元的风险投资资金 - 最近展示了一种原型,与传统硬件相比,其延迟提高了10,000倍,并将功耗降低了“数量级”。

芯片制造商英特尔是调查硅光子学AI工作负载的另一方,为此,圣克拉拉公司的科学家们最近在一篇论文中详细介绍了可以使光学神经网络更接近现实的新技术。

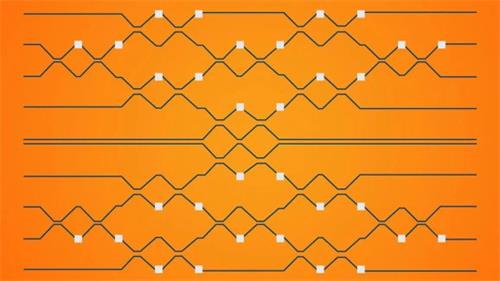

正如共同作者在今天发表的博客文章中所解释的那样,先前的工作表明,一种称为Mach-Zender干涉仪(MZI)的光子电路可以被配置为在与相位相关的量之间执行2乘2的矩阵乘法。两束光束。(在数学中,矩阵是以行和列排列的数字,符号或表达式的矩形阵列。)当这些小矩阵乘法排列在三角形网格中以创建更大的矩阵时,它们会产生一个实现矩阵向量的电路乘法,深度学习中的核心计算。

英特尔团队考虑了两种用于从MZI构建AI系统的架构:GridNet和FFTNet。GridNet可预测地将MZI排列在网格中,而FFTNet将它们插入类似蝴蝶的模式。在对手写数字识别(MNIST)的基准深度学习任务进行模拟训练后,研究人员发现,在双精度浮点精度的情况下,GridNet的精度高于FFTNet(98%对95%),但是FFTNet“显着更强大。”事实上,GridNet的性能在人工噪声的基础上降至50%以下,而FFTNet几乎保持不变。

科学家表示,他们的研究为人工智能软件培训技术奠定了基础,可以避免在制造后微调光学芯片的需要,从而节省宝贵的时间和人力。

“正如在任何制造过程中一样,存在不完善之处,这意味着芯片内部和芯片之间会有微小的变化,这些将影响计算的准确性,”英特尔AI产品组高级总监Casimir Wierzynski写道。“如果ONN要成为AI硬件生态系统的可行部分,他们将需要扩展到更大的电路和工业制造技术......我们的结果表明,提前选择正确的架构可以大大增加最终电路实现的可能性即使面对制造业的变化,他们也能达到预期的性能。“