AI代理使用日常语言提供理由来解释其行为

佐治亚理工学院的研究人员与康奈尔大学和肯塔基大学合作开发了一种人工智能(AI)代理,可以实时自动生成自然语言解释,以传达其行为背后的动机。这项工作旨在让人类与AI代理人或机器人合作,确信代理正在正确执行任务,并可以解释错误或错误行为。

代理人还使用非专家可以理解的日常用语。研究人员称之为解释或“基本原理”的目的是为了相互关联,并激发对那些可能在工作场所使用人工智能机器或在社交场合与他们互动的人的信任。

“如果人工智能的力量要实现民主化,那么无论技术能力如何,任何人都可以使用它,”Upol Ehsan博士说。乔治亚理工学院互动计算学院的学生和首席研究员。

“由于人工智能遍及我们生活的方方面面,因此非常需要以人为本的人工智能设计,使日常用户可以解释黑盒子人工智能系统。我们的工作需要一个形成性的步骤来理解基于语言的解释的作用以及如何人类认识到它们。“

该研究得到了海军研究办公室(ONR)的支持。

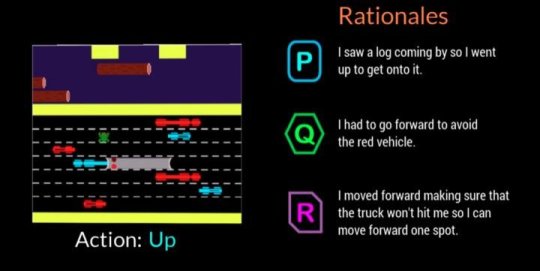

研究人员开展了一项参与者研究,以确定他们的AI代理人是否可以提供模仿人类反应的理由。观众观看了AI代理人玩电子游戏Frogger,然后按照每个人描述AI游戏移动的顺序排列了三个屏幕上的理由。

在每次移动的三个匿名理由中 - 人类生成的响应,AI代理响应和随机生成的响应 - 参与者首先首选人类生成的理论,但AI生成的响应紧随其后。

Frogger为研究人员提供了在“顺序决策环境”中培训AI的机会,这是一项重大的研究挑战,因为代理人已经做出的决策影响了未来的决策。因此,向专家解释推理链很困难,在与非专家交流时更是如此,据研究人员称。

人类观众理解Frogger的目标是让青蛙安全回家,而不会被移动的车辆撞到或淹死在河里。向上,向下,向左或向右移动的简单游戏机制允许参与者看到AI正在做什么,并评估屏幕上的基本原理是否清楚地证明了移动的合理性。

观众根据以下因素判断理由:

信心 - 此人对AI执行任务充满信心

人性化 - 看起来像是由人类制造的

充分的理由 - 充分证明采取的行动是正确的

可理解性 - 帮助人们理解AI的行为

由参与者排名较高的AI产生的理论基础是那些表现出对环境条件和适应性的认可的理论,以及那些传达对未来危险的认识并为其规划的理论。刚刚陈述明显或错误描述环境的冗余信息被发现会产生负面影响。

“这个项目更多的是了解人类对这些人工智能系统的认知和偏好,而不是建立新技术,”Ehsan说。“可解释性的核心是理智创造。我们试图理解这个人为因素。”

第二项相关研究验证了研究人员设计AI代理的决定,以便能够提供两种不同类型的理由中的一种:

简洁,“专注”的理由或

整体的,“完整的图片”理由

在第二项研究中,参与者在观看AI玩Frogger后才获得AI生成的理由。他们被要求在人工智能出错或意外行为的情况下选择他们喜欢的答案。他们不知道理由分为两类。

参赛者以3比1的比例赞成分类为“完整图片”类别的答案。回应显示,人们对AI考虑未来的步骤感到欣赏,而不仅仅是当下的情况,这可能使他们更容易犯下另一个错误。人们也想知道更多,以便他们可以直接帮助AI修复错误的行为。

“对人工智能机器人的感知和偏好的理解能够为我们提供一套强大的可操作的见解,帮助我们设计出更好的以人为本,理性生成的自主代理人,”互动计算教授马克里德尔说。该项目的首席教员。

未来可能的研究方向将把研究结果应用于各种类型的自主代理,例如伴侣代理,以及它们如何根据手头的任务做出反应。研究人员还将研究代理人如何在不同情况下做出反应,例如在紧急响应期间或在教室帮助教师时。

该研究于3月在计算机协会2019智能用户界面会议上发布。该论文的标题是“自动生成基本原理:可解释AI的技术及其对人类感知的影响”。Ehsan将在5月4日至9日在苏格兰格拉斯哥举行的ACM CHI 2019会议上,在即将出现的以人为中心的机器学习研讨会上发表一篇强调以人为本的可解释人工智能系统的设计和评估挑战的立场文件。

标签: AI代理