使用NVIDIA了解JetsonOrin上的深度学习加速器

2022-08-04 09:25:45

•

来源:

导读 开发人员或有兴趣了解更多关于NVIDIAJetsonOrin迷你PC上的深度学习加速器的开发人员将很高兴得知NVIDIA在其技术博客上发表了一篇新文章,概

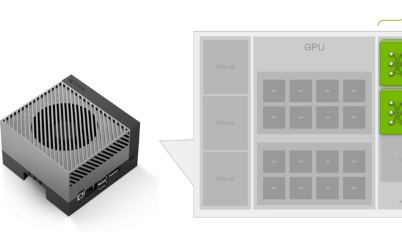

开发人员或有兴趣了解更多关于NVIDIAJetsonOrin迷你PC上的深度学习加速器的开发人员将很高兴得知NVIDIA在其技术博客上发表了一篇新文章,概述了深度学习加速器(DLA)的使用情况Jetson系统将CPU和GPU组合成一个模块。为开发人员提供可在边缘部署的小型低功耗封装中的扩展NVIDIA软件堆栈。

“虽然DLA没有GPU那么多的支持层,但它仍然支持许多流行的神经网络架构中使用的各种层。在许多情况下,层支持可能会满足您模型的要求。例如,NVIDIATAO工具包包括DLA支持的各种预训练模型,范围从对象检测到动作识别。“

“虽然需要注意的是,DLA吞吐量通常低于GPU,但它非常节能,可以让您卸载深度学习工作负载,让GPU腾出时间来处理其他任务。或者,根据您的应用程序,您可以同时在GPU和DLA上运行相同的模型,以实现更高的净吞吐量。”

“许多NVIDIAJetson开发人员已经在使用DLA成功优化他们的应用程序。Postmates利用DLA和GPU在JetsonAGXXavier上优化了他们的送货机器人应用程序。菜鸟ET实验室使用DLA优化他们的物流车辆。如果您希望全面优化您的应用程序,那么DLA是Jetson曲目中需要考虑的重要部分。“

有关将深度学习加速器与JetsonOrin一起使用的更多信息,请通过以下链接访问NVIDIA官方博客。

标签:

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如有侵权行为,请第一时间联系我们修改或删除,多谢。