机器学习模型可以让机器人像人类一样理解交互

当人类看一个场景时,他们会看到物体以及它们之间的关系。在您的办公桌上,可能有一台笔记本电脑放在电话的左侧,在电脑显示器的前面。许多深度学习模型很难以这种方式看待世界,因为它们不了解单个对象之间的纠缠关系。如果不了解这些关系,设计用于帮助厨房中的人的机器人将难以遵循“拿起炉子左侧的抹刀并将其放在砧板顶部”这样的命令。

为了解决这个问题,麻省理工学院的研究人员开发了一种模型,可以理解场景中对象之间的潜在关系。他们的模型一次表示一种个体关系,然后结合这些表示来描述整个场景。这使模型能够从文本描述中生成更准确的图像,即使场景包含多个以不同关系排列的对象也是如此。

这项工作可应用于工业机器人必须执行复杂的多步骤操作任务的情况,例如在仓库中堆叠物品或组装电器。它还使该领域更接近于使机器能够像人类一样从环境中学习并与之交互。

“当我看一张桌子时,我不能说XYZ位置有一个物体。我们的大脑不是那样工作的。在我们的脑海中,当我们理解一个场景时,我们真正理解它是基于它们之间的关系对象。我们认为,通过构建一个可以理解对象之间关系的系统,我们可以使用该系统更有效地操纵和改变我们的环境,”博士YilunDu说。计算机科学与人工智能实验室(CSAIL)的学生和论文的共同主要作者。

Du与共同主要作者李双(CSAIL博士)共同撰写了这篇论文。学生,以及伊利诺伊大学厄巴纳-香槟分校的研究生NanLiu;以及JoshuaB.Tenenbaum,脑与认知科学系的PaulE.Newton认知科学与计算职业发展教授,CSAIL成员;资深作者AntonioTorralba,DeltaElectronics电气工程和计算机科学教授,CSAIL成员。该研究将在12月的神经信息处理系统会议上发表。

一次一个关系

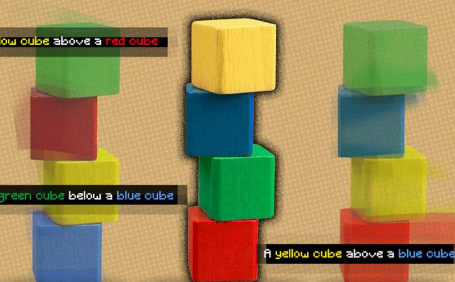

研究人员开发的框架可以根据对象及其关系的文本描述生成场景图像,例如“蓝色凳子左侧的木桌。蓝色凳子右侧的红色沙发。”

研究人员开发的框架可以根据对象及其关系的文本描述生成场景图像,在该图中,研究人员的最终图像在右侧并正确遵循文本描述。图片来源:麻省理工学院

他们的系统会将这些句子分解成两个更小的部分来描述每个人的关系(“蓝色凳子左边的木桌”和“蓝色凳子右边的红色沙发”),然后分别对每个部分建模.然后通过生成场景图像的优化过程组合这些片段。

研究人员使用一种称为基于能量的模型的机器学习技术来表示场景描述中的各个对象关系。这种技术使他们能够使用一个基于能量的模型来编码每个关系描述,然后以推断所有对象和关系的方式将它们组合在一起。

李解释说,通过将每个关系的句子分解成更短的片段,系统可以以多种方式重新组合它们,因此它能够更好地适应以前从未见过的场景描述。

“其他系统会从整体上获取所有关系,并从描述中一次性生成图像。但是,当我们有分布外的描述时,例如具有更多关系的描述,这些方法会失败,因为这些模型无法真正适应一次拍摄生成包含更多关系的图像。然而,当我们将这些单独的、较小的模型组合在一起时,我们可以对更多的关系进行建模并适应新的组合,“杜说。

该系统也可以反向工作——给定一张图像,它可以找到与场景中对象之间的关系相匹配的文本描述。此外,他们的模型可用于通过重新排列场景中的对象来编辑图像,使它们与新的描述相匹配。

理解复杂场景

研究人员将他们的模型与其他深度学习方法进行了比较,这些方法给出了文本描述,并负责生成显示相应对象及其关系的图像。在每种情况下,他们的模型都优于基线。

他们还要求人类评估生成的图像是否与原始场景描述匹配。在描述包含三个关系的最复杂示例中,91%的参与者得出结论认为新模型的性能更好。

在这个图中,研究人员的最终图像被标记为“我们的”。图片来源:麻省理工学院

“我们发现的一件有趣的事情是,对于我们的模型,我们可以将句子从一个关系描述增加到两个、三个甚至四个描述,并且我们的方法继续能够生成被那些描述正确描述的图像。描述,而其他方法失败,”杜说。

研究人员还展示了它以前从未见过的场景的模型图像,以及每张图像的几种不同的文字描述,它能够成功识别出与图像中物体关系最匹配的描述。

当研究人员向系统提供描述相同图像但以不同方式描述的两个相关场景描述时,模型能够理解这些描述是等效的。

研究人员对他们模型的稳健性印象深刻,尤其是在处理之前从未遇到过的描述时。

“这是非常有前途的,因为它更接近人类的工作方式。人类可能只会看到几个例子,但我们可以从这几个例子中提取有用的信息,并将它们组合在一起,创造出无限的组合。我们的模型有这样一个特性,允许它从更少的数据中学习,但可以推广到更复杂的场景或图像生成,”李说。

虽然这些早期结果令人鼓舞,但研究人员希望了解他们的模型如何在更复杂的真实世界图像上执行,这些图像具有嘈杂的背景和相互阻挡的物体。

他们也有兴趣最终将他们的模型整合到机器人系统中,使机器人能够从视频中推断对象关系,然后应用这些知识来操纵世界上的对象。

“开发可以处理我们周围世界的组成性质的视觉表示是计算机视觉中的关键开放问题之一。本文通过提出一个基于能量的模型,该模型在这个问题上取得了重大进展,该模型明确地对对象之间的多重关系进行建模图像中描绘的。结果确实令人印象深刻,“捷克技术大学捷克信息学、机器人和控制论研究所的杰出研究员约瑟夫·西维克说,他没有参与这项研究。

标签: