最新的CPU将英特尔的性能提高了一倍

老实说,我很难确定这两个公告中哪一个值得关注。两者都很令人兴奋。一种扩展了AMD在服务器CPU方面超过英特尔的领导地位,另一种则将这些快速CPU与Qualcomm Cloud A100加速器结合在一起。由于技嘉服务器是第一款具有这400种TOPS推理引擎的产品,因此这是一个重要的里程碑。因此,请跳到最后,但我将从EPYC发布开始,这本身就是很史诗的。

AMD宣布了什么内容,它与之相比有何不同?

不出所料,AMD宣布了该公司的第三代EPYC服务器CPU,声称其性能是英特尔竞争性至强芯片的两倍。新型EPYC 7003比其前任产品的单周期性能提高了19%,并使AI推理处理中使用的8位整数运算的性能提高了一倍。有趣的是,AMD声称新CPU在每个芯片和每个内核上提供了世界上最快的性能。与英特尔至强相比,新的EPYC 7003具有更多,更快的内核,其性能是英特尔在云,企业和HPC工作负载中最快的产品。

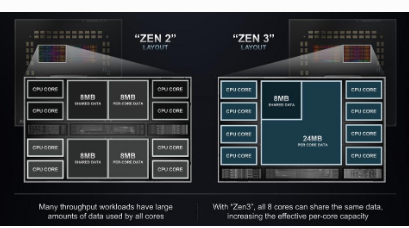

类似于其前身,7003系列展示了设计师如何越来越多地使用“小芯片”,而不是构建难以生产的整体式大规模模具。EPYC 7003 SOC布局是连接到四个处理器芯片的中央集线器芯片,每个处理器芯片具有16个内核。集线器芯片最多支持8个存储通道和通常的I / O。除了专用于每个内核的L2缓存外,Zen 3内核现在还支持32MB L3缓存,该缓存在4内核组合系统中共享。

AMD首次通过实现本机8位整数运算消除了AI所享有的巨大AI性能差距,这使AI推理处理吞吐量翻了一番。如果您是云服务提供商,则必须将Xeons用于AI,将AMD用于其他所有功能。对于用户和CSP而言,这确实很尴尬。好的举动,AMD。

AMD将EPYC SKU分为三类:适用于HPC等工作负载的每个内核最快的性能,用于每个服务器的最大虚拟机的大量内核以及用于减少内核数量和成本的“平衡和优化”。

让我们回到最大的CPU客户CSP。AMD声称,新的EPYC芯片与竞争对手相比可以将总拥有成本降低35%。那是巨大的。这种优势将在未来几年内加速AMD市场份额的增长,直到英特尔新任首席执行官Pat Gelsinger解决了英特尔的制造问题和以单芯片为中心的产品路线图。以前,AMD吹捧基于每台服务器具有更多内核,从而降低了总拥有成本,但遭受了每内核绝对性能的劣势,这推迟了一些潜在的采用者。这种赤字已不再是事实。

在EYPC发布的同时,技嘉和高通宣布了一款新的AI服务器,其中包含2个EPYC和16个Cloud AI100。正如我经常报道的那样,每只AI100在半高半长的PCIe卡中仅以75瓦的功率提供每秒400万亿次操作(TOPS)。因此,单个服务器上的16x400卡= 6.4 Peta OPS(POPS,或每秒一万亿次操作),而整个服务器机架中的POPS超过100 POPS。这只是疯狂的性能和电源效率,比那里的任何产品都要好十倍。在我的年度预测中,我预测高通公司将在2021年上半年宣布可用性并吸引客户。

高通公司的Cloud AI100仅提供75瓦功率,可提供400 TOPS的功率。

技嘉(Gigabyte)提供的新型Qualcomm Cloud AI100服务器可以为每个机架提供100多个PETA-OPS,远远超过... [+] 高通

怀疑论者指出,QTI(高通公司的技术部门)一直在谈论AI100已有近两年的历史,但该产品尚未见诸于市场,也没有客户宣布打算使用此令人印象深刻的平台。好吧,我相信迎合最大的云服务提供商的技嘉公司并不仅决定花这笔钱来兴建和测试新平台。大个子一定会说:“制造这个,我会买一些架子”。但是未知的庞然大物仍然必须在评估该平台,因此技嘉决定在X公司(或“ F”?)完成评估时腾出一些时间进行工作。敬请关注!

结论

AMD EPYC设计团队就像节拍器一样,每三年推出超过竞争对手的新产品。显然,AMD有望大幅提高其市场份额,在未来两年内可能会从大约10%增长到20或25%。同时,炙手可热的AI服务器正在使用这些高性能,低成本的芯片来构建AI服务器,包括NVIDIA DGX和现在的技嘉服务器。

标签: 英特尔